數據實時同步在當今互聯網接入及相關服務中扮演著至關重要的角色,支持高并發、低延遲的數據一致性,廣泛應用于電商、金融、物聯網等場景。本文將全面解析數據實時同步方案,涵蓋核心概念、技術選型、架構設計、代碼實現及優化建議,并附上詳細的架構圖,旨在為開發者和架構師提供實用參考。建議收藏本文,以便隨時查閱。

一、數據實時同步概述

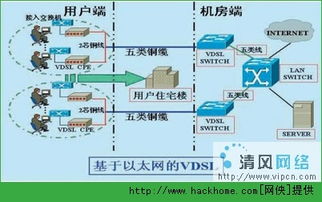

數據實時同步是指數據在多個系統或節點間實現毫秒級或秒級的一致性更新,確保用戶或應用在任何時間點訪問的數據都是最新的。其核心要求包括低延遲、高可用性、數據一致性和可擴展性。在互聯網接入服務中,如用戶會話同步、實時推薦系統、多數據中心備份等,實時同步是基礎支撐。

二、核心技術選型

實現數據實時同步的常用技術包括:

- 消息隊列:如Kafka、RabbitMQ,用于異步數據傳輸,支持高吞吐。

- CDC(Change Data Capture):通過數據庫日志(如MySQL binlog)捕獲數據變更,實現準實時同步。

- 流處理框架:如Apache Flink、Spark Streaming,處理實時數據流。

- 數據庫復制工具:如Debezium、Canal,用于數據庫間的實時同步。

選擇技術時需考慮數據量、延遲要求、系統復雜度等因素。例如,Kafka適合高吞吐場景,而Flink支持復雜事件處理。

三、架構設計詳解

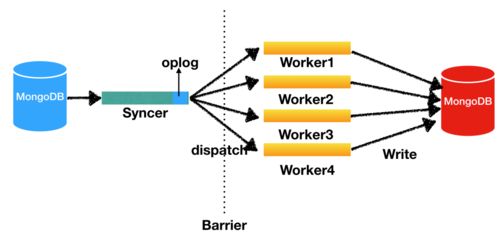

一個典型的數據實時同步架構包括數據源、采集層、處理層和目標存儲。以下是基于CDC和消息隊列的通用架構:

1. 數據源層:如MySQL、PostgreSQL數據庫,通過binlog或WAL日志輸出變更數據。

2. 采集層:使用Debezium或Canal監聽數據庫日志,將變更事件發布到消息隊列(如Kafka)。

3. 處理層:通過流處理引擎(如Flink)消費Kafka消息,進行數據清洗、轉換或聚合。

4. 目標存儲層:將處理后的數據寫入目標系統,如Elasticsearch用于搜索,或另一個數據庫用于備份。

架構圖示例:`

[數據源: MySQL] -> [CDC工具: Debezium] -> [消息隊列: Kafka] -> [流處理: Flink] -> [目標: Elasticsearch/Redis]`

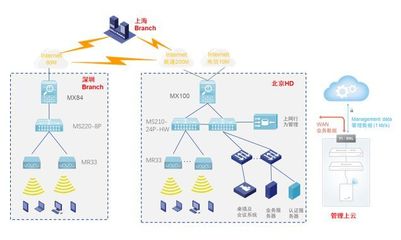

此架構支持水平擴展,通過分區和副本機制確保高可用性。在多數據中心場景中,可結合網關和負載均衡實現跨區域同步。

四、代碼實現示例

以下是一個基于Java和Kafka的簡單數據同步代碼示例,使用Debezium捕獲MySQL變更并發布到Kafka:

`java

// 使用Debezium配置MySQL連接器

public class MySQLCDCConnector {

public static void main(String[] args) {

Configuration config = Configuration.create()

.with("connector.class", "io.debezium.connector.mysql.MySqlConnector")

.with("database.hostname", "localhost")

.with("database.port", "3306")

.with("database.user", "user")

.with("database.password", "password")

.with("database.server.id", "184054")

.with("database.server.name", "my-app-connector")

.with("table.whitelist", "testdb.users")

.with("database.history.kafka.bootstrap.servers", "kafka:9092")

.with("database.history.kafka.topic", "dbhistory.test")

.build();

// 啟動連接器并發布變更到Kafka主題

Engine engine = Engine.create(config);

engine.run();

}

}

// Kafka消費者處理數據(使用Spring Kafka示例)

@KafkaListener(topics = "my-app-connector.testdb.users")

public void consume(ConsumerRecord

// 解析變更數據并寫入目標系統

String key = record.key();

String value = record.value();

System.out.println("Received change: " + value);

// 這里可添加邏輯,如寫入Elasticsearch或另一個數據庫

}`

此代碼演示了如何捕獲MySQL中users表的變更,并通過Kafka進行傳輸。在實際應用中,需添加錯誤處理、監控和性能優化。

五、優化與最佳實踐

為確保實時同步的穩定性和效率,建議:

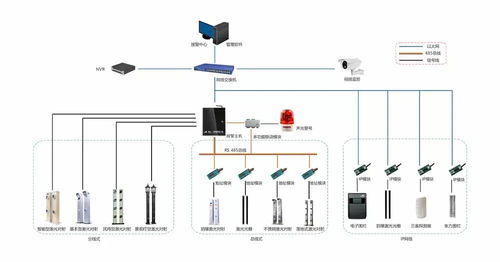

- 監控與告警:使用Prometheus和Grafana監控吞吐量、延遲和錯誤率。

- 數據一致性:采用冪等寫入或分布式事務(如Saga模式)避免重復數據。

- 性能調優:調整Kafka分區數、Flink并行度,以及數據庫索引。

- 容災設計:通過多活架構或備份鏈路防止單點故障。

在互聯網接入服務中,結合API網關和CDN可進一步提升用戶體驗。

六、總結與展望

數據實時同步是互聯網服務的基石,本文從理論到實踐全面覆蓋了方案設計。隨著5G和邊緣計算的發展,實時同步將更注重低延遲和分布式協同。建議讀者結合自身業務需求,靈活應用上述技術,并持續關注開源社區更新。收藏本文,助你在數據同步領域游刃有余。如需更詳細代碼或架構圖,可參考GitHub相關項目或官方文檔。